Tecnología de transmisión en vivo: pasado, presente y futuro

- SplitmediaLabs Limited

- 5 oct 2024

- 4 Min. de lectura

Procesadores NPU y tecnología de IA

Puede parecer que la transmisión en vivo se ha realizado exactamente igual durante los últimos años. Sin embargo, en el fondo, las nuevas capacidades de hardware, las tecnologías de codificación y las innovaciones técnicas han estado transformando constantemente el panorama subyacente. Cuando me uní a XSplit en 2012, la transmisión en vivo apenas empezaba a cobrar impulso. Desde entonces, he disfrutado de primera fila de los increíbles avances tecnológicos que han transformado y siguen transformando la industria.

Uno de los cambios más significativos que hemos visto es la transición de la codificación basada en CPU a la codificación por hardware en la GPU. Este cambio no fue solo una pequeña mejora; fue una revolución, ya que hizo que el streaming fuera accesible para el público general, al no requerir un equipo de streaming prohibitivamente caro con una CPU potente para producir una transmisión en vivo HD de alta calidad. Grandes empresas como Intel, Nvidia y AMD lanzaron sus propios codificadores dedicados, reconociendo el profundo impacto que la creación de contenido en vivo estaba comenzando a tener en nuestro mundo digital.

Una nueva arquitectura de chips está revolucionando el panorama con la llegada de las NPU (Unidades de Procesamiento Neuronal). Estos chips son revolucionarios para las tareas impulsadas por IA, que ahora pueden ejecutarse con mayor fluidez sin sobrecargar la CPU ni la GPU. Intel es un impulsor de este cambio, ya que está integrando NPU en todas las nuevas CPU para portátiles y la mayoría de las CPU para ordenadores de escritorio para hacer realidad su visión de PC con IA.

Para los creadores de contenido, esto hará que sea aún más accesible en el futuro aprovechar las mejoras basadas en IA en la experiencia del creador, como la eliminación de fondo impulsada por IA, mejoras de audio, reconocimiento de momentos destacados del juego, subtítulos, reacciones automatizadas y mucho más, sin afectar negativamente el juego o la calidad de la transmisión.

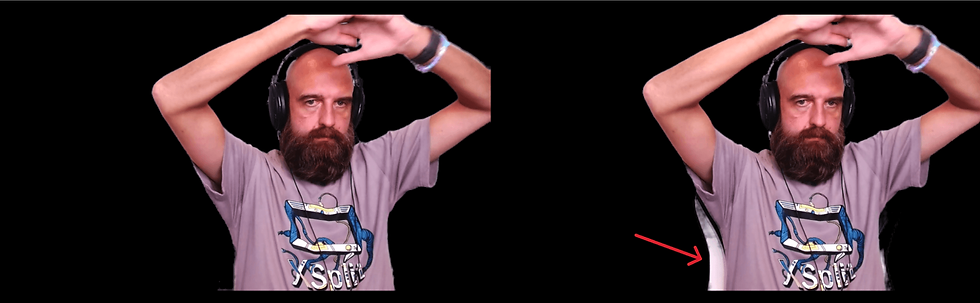

En XSplit, hemos aprovechado la potencia de las NPU de maneras fascinantes. Nos asociamos con Intel para mejorar nuestro software VCam, que utiliza nuestra tecnología patentada de IA para la eliminación del fondo de la cámara web. Al ejecutarse en un equipo con NPU, por ejemplo, cualquier equipo con el nuevo procesador Intel Core Ultra, VCam ahora ofrece un modelo más potente que ofrece resultados notablemente mejores, especialmente con detalles difíciles como los bordes de las sillas, los auriculares o cuando alguien se mueve repentinamente en el fondo.

La mejora del rendimiento es evidente: al compararlo con la eliminación perfecta de todos los elementos del fondo, nuestro mejor modelo de IA anterior presentaba una tasa de inexactitud promedio del 2,5 %, pero con el nuevo modelo optimizado para NPU, esta se reduce a tan solo el 1,5 %, lo que representa una reducción del 40 % en las inexactitudes. Si bien la tasa de inexactitud puede parecer insignificante en ambos casos, esta mejora marca una diferencia real en la transmisión en vivo, donde la claridad y la calidad visual son cruciales para la interacción del espectador.

Ejemplos:

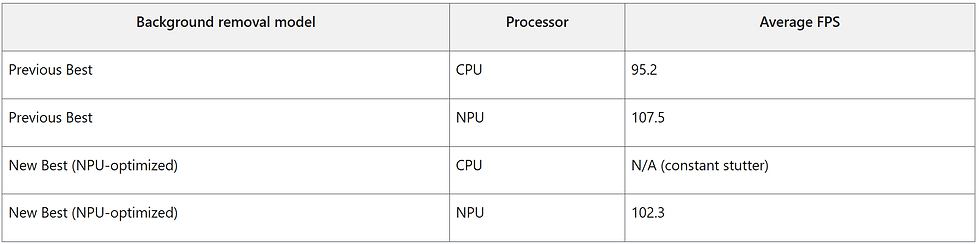

Así es como funciona en la vida real: Realizamos una serie de pruebas en vivo en una ASUS Zenbook con un procesador Intel Core Ultra 7 con NPU y una tarjeta gráfica Intel Arc. Evaluamos el impacto en los FPS al jugar a juegos populares como Cyberpunk 2077, Los Sims 4 y Fortnite, codificando la partida a 720p en XSplit Broadcaster y ejecutando los modelos de eliminación de fondo de mayor calidad tanto en la CPU como en la NPU.

Los resultados fueron impresionantes. Los juegos funcionaron con fluidez, con un impacto mínimo en la velocidad de fotogramas cuando la NPU se encargó del procesamiento en segundo plano.

En estos escenarios, al ejecutar el mejor modelo de eliminación de fondo anterior en la NPU, observamos un promedio de FPS aproximadamente un 13 % mayor en los juegos en comparación con el modelo en la CPU. Por el contrario, al ejecutar el nuevo modelo de rendimiento optimizado para la NPU en la CPU, el juego presentaba un tirones constantes, mientras que al ejecutar el nuevo modelo en la NPU, la experiencia era fluida con un 7,5 % más de FPS promedio que al ejecutar el mejor modelo anterior en la CPU.

También vimos importantes ahorros de energía y mejoras en la duración de la batería al ejecutar cualquiera de los modelos de IA de eliminación de fondo en la NPU.

VCam utiliza la API OpenVINO de Intel para la inferencia en CPU y NPU. De forma predeterminada, la inferencia en VCam utiliza precisión FP16 en NPU y GPU, y cuantificación Int8 en CPU. En una próxima actualización, VCam podría cambiar a usar Int8 también en NPU para un consumo de energía aún menor.

VCam optimiza los ciclos de inferencia cuando la cámara tiene poco o ningún movimiento, pero al usar nuestra herramienta de prueba de modelos interna pudimos medir el consumo de energía en el peor de los casos utilizado por el modelo de eliminación de fondo al forzar la inferencia en cada cuadro y probar diferentes modelos con diferentes precisiones.

En conclusión, usar la NPU para la inferencia en segundo plano redujo el consumo de batería hasta en un 60 % en comparación con la inferencia en la CPU/GPU, y ejecutar el nuevo modelo superior en la NPU solo aumenta el consumo de energía aproximadamente un 8 % en comparación con el mejor modelo anterior. En resumen, esto se traduce en una mayor duración de la batería y una factura de energía más baja, lo que beneficia tanto a los streamers como al planeta.

De cara al futuro, el potencial de las NPU en la creación de contenido es enorme. Apenas estamos explorando las posibilidades en cuanto a análisis de video en tiempo real, moderación automatizada e interacciones personalizadas. Imagine una transmisión en vivo que se adapta automáticamente a las reacciones y comentarios de los espectadores, creando una experiencia verdaderamente interactiva.

En esta serie, seguiremos explorando las tecnologías que moldean el pasado, el presente y el futuro de la transmisión en vivo. Manténganse al tanto para descubrir más sobre cómo estas innovaciones están redefiniendo no solo la forma en que creamos contenido, sino también cómo nos conectamos con el mundo.

Comentarios